Práctica Práctica con el Stack ELK

Serie de Blogs de SIEM & Monitoreo: ELK Stack

En esta segunda entrega de nuestra mini-serie sobre ELK Stack dentro de la más amplia Serie de Blogs de SIEM & Monitoreo, pasamos de conceptos fundamentales a la implementación práctica. Esta publicación te guiará a través de la configuración de un entorno de prueba funcional de ELK utilizando Docker en una máquina virtual Ubuntu, dándote un espacio para explorar cómo Elasticsearch, Logstash y Kibana trabajan juntos para procesar y visualizar datos.

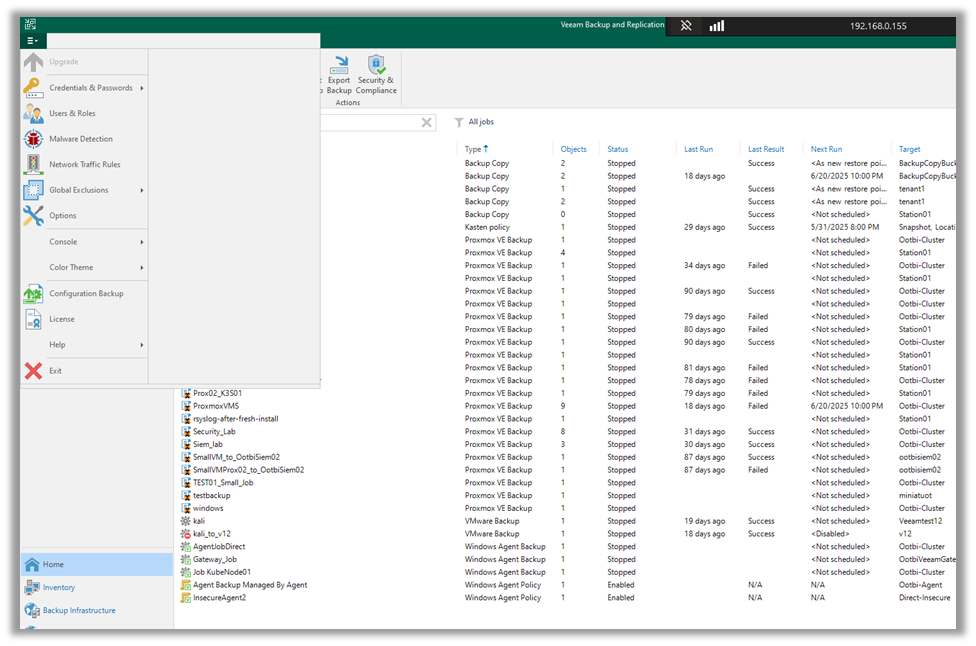

Ya seas un administrador de copias de seguridad o un profesional de TI, esta guía ofrece un laboratorio personalizable donde puedes experimentar con el análisis de mensajes Syslog de Veeam Backup & Replicación y reenviarlos a tu stack ELK. El objetivo es proporcionar un entorno seguro y flexible para aprender y probar, no para despliegue en producción.

Configuración de Docker

Requisitos: Necesitarás una VM de servidor Ubuntu.

1. Primero, instalaremos Docker:

sudo apt install docker.io

sudo apt install docker-compose -y

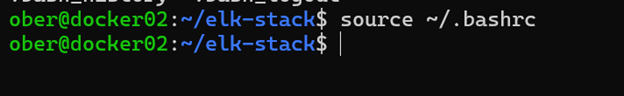

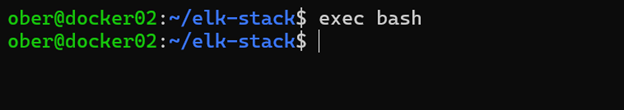

sudo usermod -aG docker $USER 2. Cierra sesión y vuelve a iniciar sesión, o ejecuta uno de estos comandos:

source ~/.bashrc

exec bash

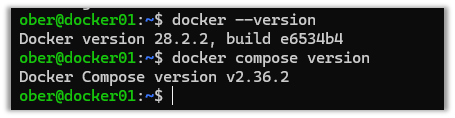

3. Cierra sesión y vuelve a iniciar sesión para verificar que Docker se instaló correctamente.

docker --version

docker compose version

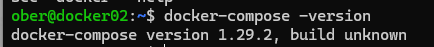

4. Dependiendo de la versión, el comando de Docker Compose podría aparecer así:

5. Clona este repositorio de GitHub: https://github.com/object1st/elk-stack.git

git clone https://github.com/object1st/elk-stack.git6. Entra en la carpeta.

cd elk-stack/7. Ejecuta este comando:

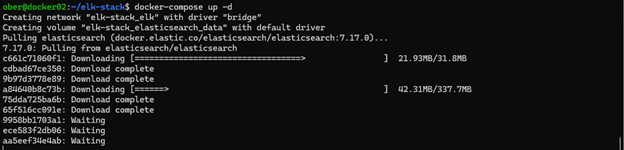

docker-compose up -d8. Los contenedores se descargarán y luego se iniciarán.

9. Verifica que alguno de los siguientes contenedores esté en ejecución:

docker ps

docker-compose ps

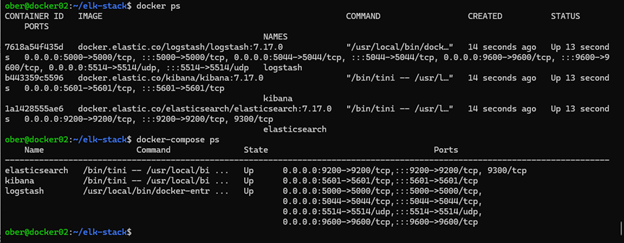

Accediendo a Kibana en tu Navegador

Ahora que todo está configurado, puedes abrir Kibana en tu navegador. Por defecto, Kibana se ejecuta en el puerto 5601, así que necesitarás navegar a la URL apropiada según donde esté alojado tu entorno Docker.

Por ejemplo, si tu configuración de Docker se está ejecutando en una VM llamada docker01, irías a:

Si tu VM tiene un nombre DNS personalizado como geoffsvm, entonces la URL sería: http://geoffsvm:5601

Alternativamente, si no tienes un nombre DNS configurado, puedes usar la dirección IP de la VM en su lugar:

http://[tu-ip-vm]:5601:5601

En última instancia, solo asegúrate de que estás apuntando al host correcto y usando el puerto 5601, que es el predeterminado para Kibana.

Nota: Si en algún momento deseas comenzar de nuevo, realiza los siguientes pasos para borrar la configuración:

Para eliminar todos los contenedores, redes y volúmenes, ejecuta los siguientes comandos:

docker compose down --volumes --remove-orphans

docker system prune -a --volumes -fConfigurando Veeam VBR para Enviar Datos Syslog a ELK

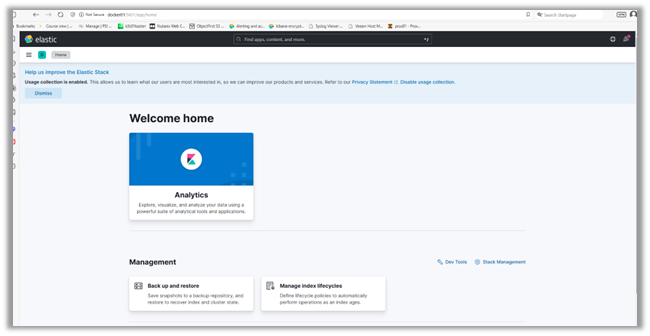

Para ingerir registros en nuestra configuración y ver cómo está funcionando, configuraremos Veeam VBR para reenviar sus mensajes syslog a ELK:

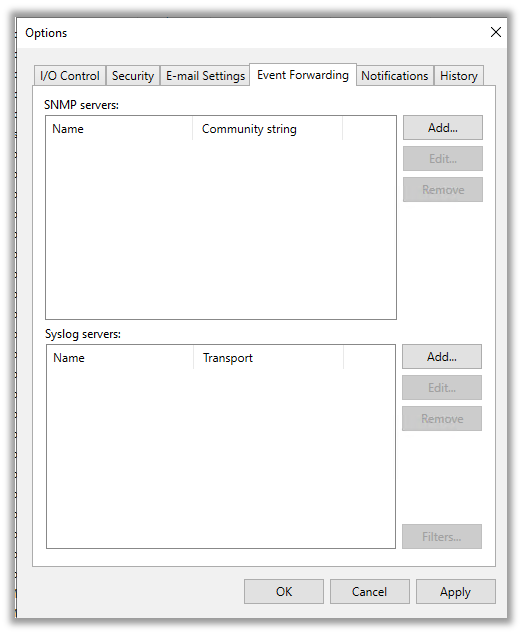

1. Ve al menú desplegable en la esquina superior izquierda y haz clic en “Opciones.”

2. Luego haz clic en la “Pestaña de Reenvío de Eventos.”

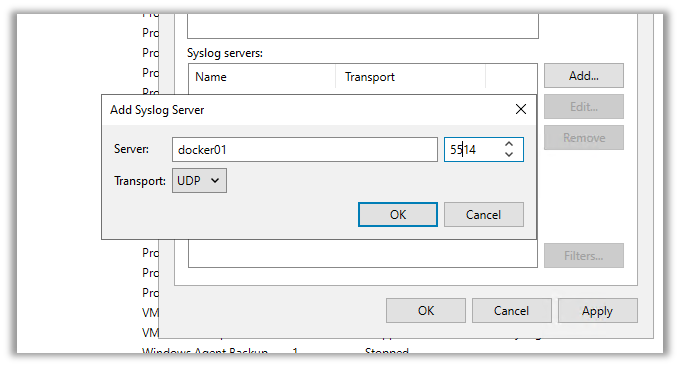

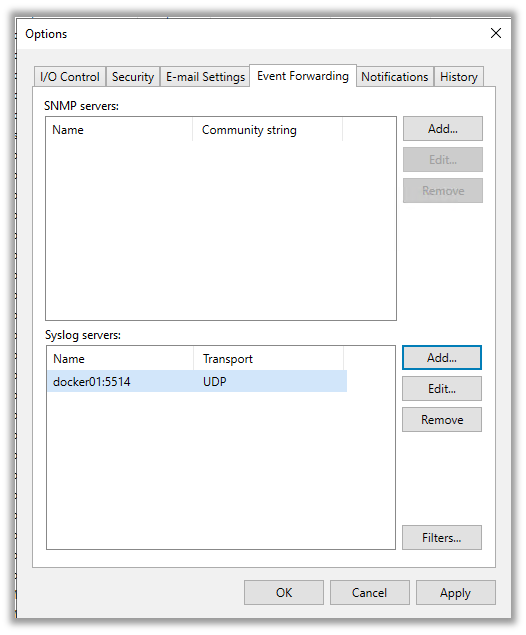

3. Aquí, agregaremos el servidor syslog que creamos en Docker. Haz clic en “Agregar” y escribe los detalles. Luego, haz clic en cualquiera de:

- “Aplicar” para guardar y cerrar la ventana.

- “OK” para guardar y mantener la ventana abierta.

Una vez que presiones aplicar o ok, Veeam enviará su primer mensaje syslog de prueba a Elasticsearch.

Verificar el Descubrimiento de Registros en Kibana

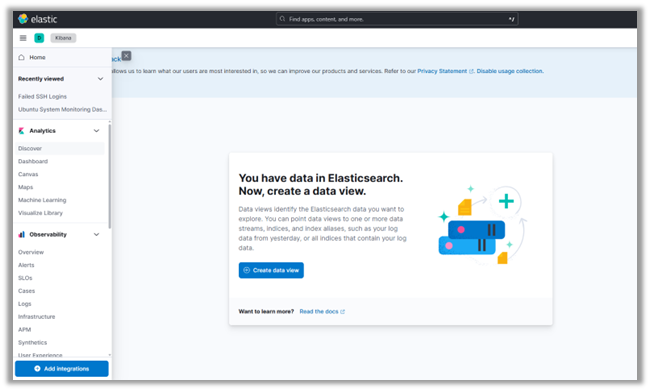

1. Navega de regreso a la interfaz de Kibana.

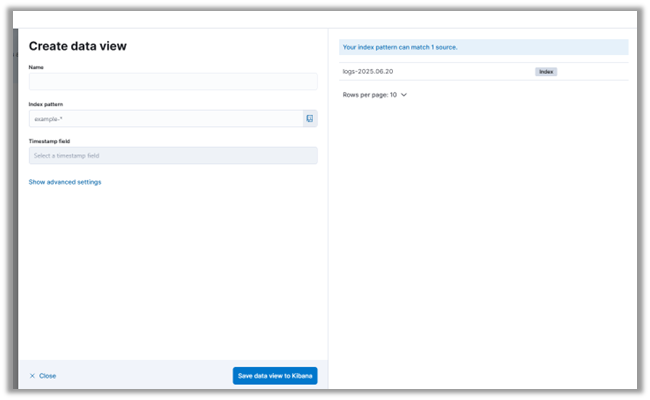

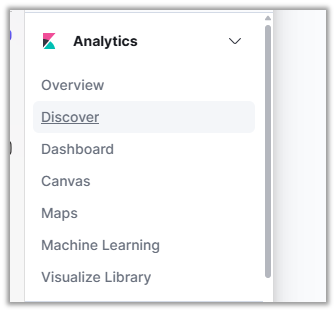

2. En el menú desplegable en la esquina superior izquierda, haz clic en “Descubrir.” Allí se te presentará una invitación para crear un nuevo Patrón de Índice, incluyendo una vista de los datos syslog por campo:

3. Haz clic en “Crear Patrón de Índice.”

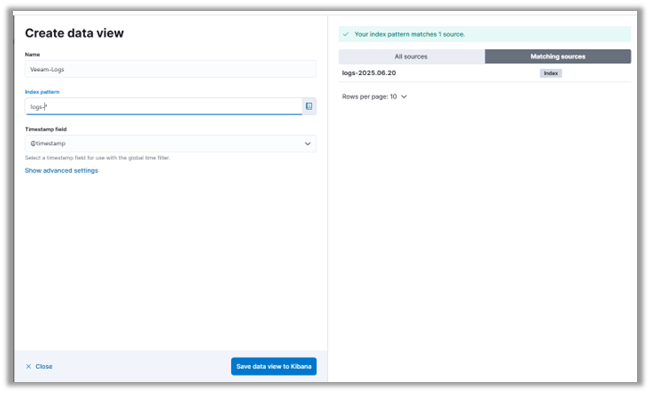

4. Puedes ver que nuestro servidor Elasticsearch ya ha recibido algunos mensajes syslog de Veeam. Cuando configuras los ajustes del servidor syslog en Veeam, automáticamente envía un mensaje de prueba. Esto te permite verificar que tu sistema de monitoreo o SIEM está recibiendo los registros correctamente.

5. Nombraremos nuestro Patrón de Índice Veeam_Logs y utilizaremos un Patrón de Índice que coincida con los registros ya ingeridos.

6. Haz clic en “Guardar Patrón de Índice en Kibana.”

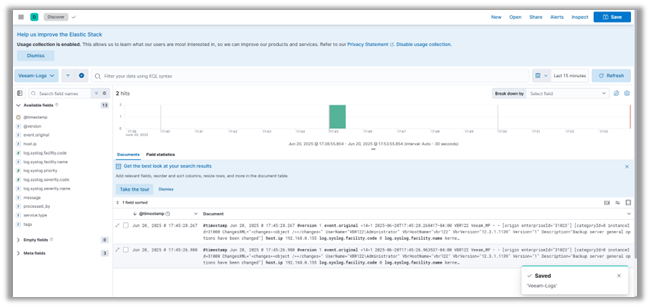

7. Presiona "Descubrir" en el menú del lado izquierdo de la página para ver los mensajes de registro de VBR.

Conclusión

Con tu laboratorio ELK en funcionamiento, has dado un gran paso hacia la construcción de un entorno SIEM funcional. En esta publicación, recorrimos la configuración de contenedores Docker para Elasticsearch, Logstash y Kibana, configuramos un pipeline de Logstash para mensajes syslog de Veeam, y exploramos esos registros en Kibana. Ahora tienes una base sólida para ingerir y visualizar datos de registro en un entorno de prueba controlado.

En la próxima publicación de la mini-serie, construiremos sobre esta base profundizando en Elastic Security y explorando cómo mejora la detección de amenazas y la alerta dentro del ecosistema ELK. También presentaremos Fluentd como una alternativa a Logstash, comparando las dos herramientas y mostrando cómo configurar Fluentd para reenviar registros a Elasticsearch. Si estás interesado en casos de uso de monitoreo de seguridad, creación de paneles y optimización de tu pipeline de registros, no querrás perderte lo que viene a continuación.