Pratique concrète avec la pile ELK

Série de blogs SIEM & Monitoring : ELK Stack

Dans cette deuxième partie de notre mini-série sur l'ELK Stack au sein de la série de blogs SIEM & Monitoring, nous passons des concepts fondamentaux à la mise en œuvre pratique. Cet article vous guide à travers la configuration d'un environnement de test ELK fonctionnel en utilisant Docker sur une machine virtuelle Ubuntu, vous offrant un bac à sable pour explorer comment Elasticsearch, Logstash et Kibana fonctionnent ensemble pour traiter et visualiser les données.

Que vous soyez un administrateur de sauvegarde ou un professionnel de l'informatique, ce guide propose un laboratoire personnalisable où vous pouvez expérimenter le parsing des messages Syslog de Veeam Backup & Replication et les transférer dans votre stack ELK. L'objectif est de fournir un environnement sûr et flexible pour l'apprentissage et les tests, et non pour le déploiement en production.

Configuration de Docker

Exigences : Vous aurez besoin d'une VM serveur Ubuntu.

1. Tout d'abord, nous allons installer Docker :

sudo apt install docker.io

sudo apt install docker-compose -y

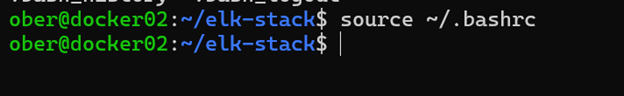

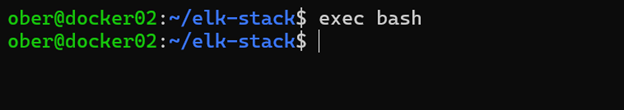

sudo usermod -aG docker $USER 2. Déconnectez-vous et reconnectez-vous, ou exécutez l'une de ces commandes :

source ~/.bashrc

exec bash

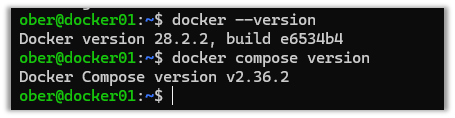

3. Déconnectez-vous et reconnectez-vous pour vérifier que Docker a été installé avec succès.

docker --version

docker compose version

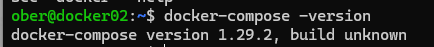

4. Selon la version, la commande Docker Compose pourrait apparaître comme ceci :

5. Clonez ce dépôt GitHub : https://github.com/object1st/elk-stack.git

git clone https://github.com/object1st/elk-stack.git6. Accédez au dossier.

cd elk-stack/7. Exécutez cette commande :

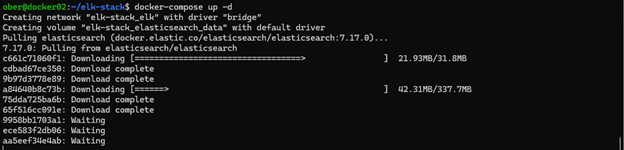

docker-compose up -d8. Les conteneurs seront téléchargés puis démarrés.

9. Vérifiez que l'un des conteneurs suivants est en cours d'exécution :

docker ps

docker-compose ps

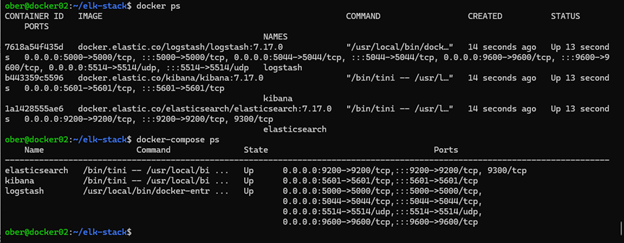

Accéder à Kibana dans votre navigateur

Maintenant que tout est configuré, vous pouvez ouvrir Kibana dans votre navigateur. Par défaut, Kibana fonctionne sur le port 5601, vous devrez donc naviguer vers l'URL appropriée en fonction de l'endroit où votre environnement Docker est hébergé.

Par exemple, si votre configuration Docker fonctionne sur une VM nommée docker01, vous iriez à :

Si votre VM a un nom DNS personnalisé comme geoffsvm, alors l'URL serait : http://geoffsvm:5601

Alternativement, si vous n'avez pas de nom DNS configuré, vous pouvez utiliser l'adresse IP de la VM à la place :

http://[votre-ip-vm]:5601:5601

En fin de compte, assurez-vous simplement que vous pointez vers l'hôte correct et que vous utilisez le port 5601, qui est le port par défaut pour Kibana.

Remarque : Si à tout moment vous souhaitez repartir de zéro, effectuez les étapes suivantes pour effacer la configuration :

Pour supprimer tous les conteneurs, réseaux et volumes, exécutez les commandes suivantes :

docker compose down --volumes --remove-orphans

docker system prune -a --volumes -fConfigurer Veeam VBR pour envoyer des données Syslog à ELK

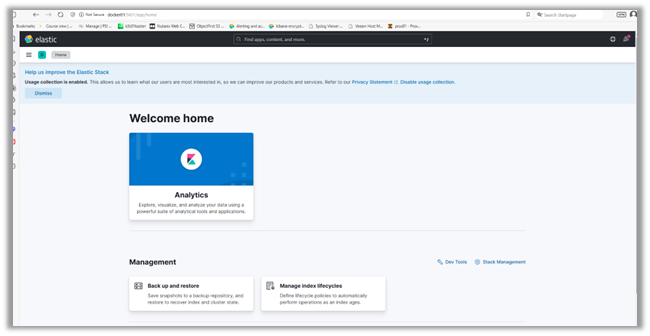

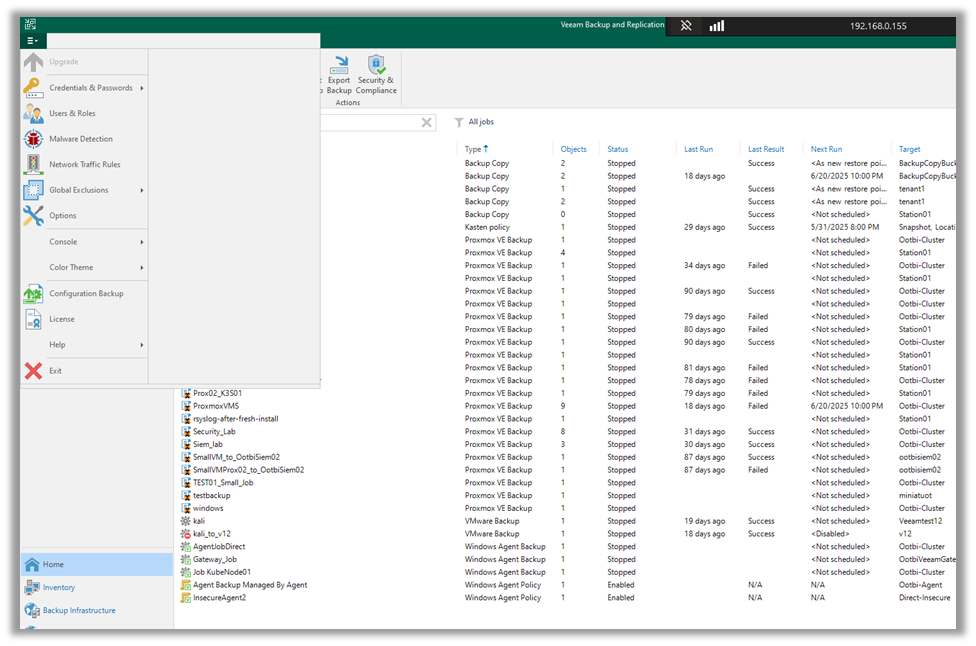

Pour ingérer des journaux dans notre configuration afin de voir comment cela fonctionne, nous allons configurer Veeam VBR pour transférer ses messages syslog à ELK :

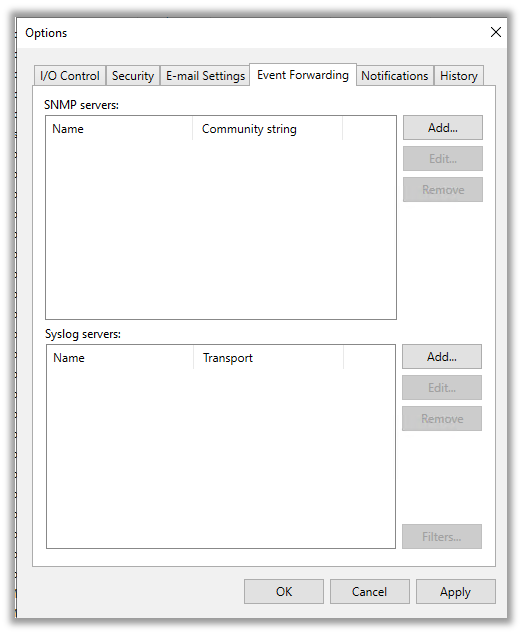

1. Allez dans le menu déroulant en haut à gauche et cliquez sur « Options ».

2. Ensuite, cliquez sur l'onglet « Transfert d'événements ».

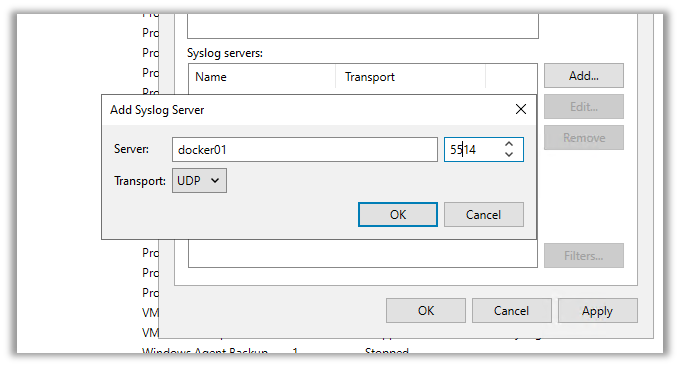

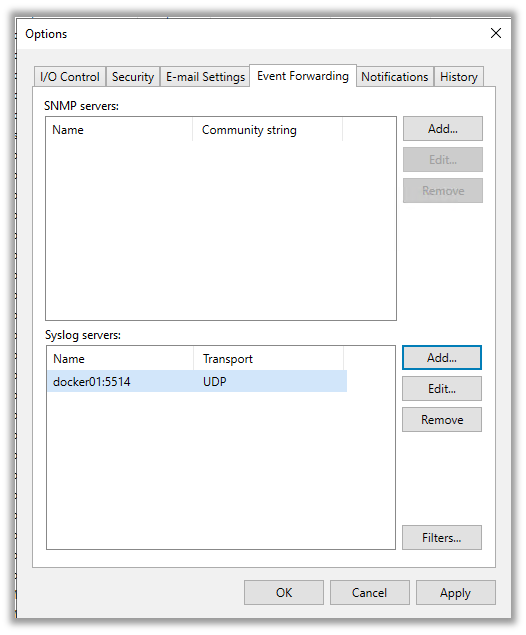

3. Ici, nous allons ajouter le serveur syslog que nous avons créé dans Docker. Cliquez sur « Ajouter » et saisissez les détails. Ensuite, cliquez sur l'un des deux :

- « Appliquer » pour enregistrer et fermer la fenêtre.

- « OK » pour enregistrer et garder la fenêtre ouverte.

Une fois que vous avez appuyé sur appliquer ou ok, Veeam enverra son premier message syslog de test à Elasticsearch.

Vérifier la découverte des journaux dans Kibana

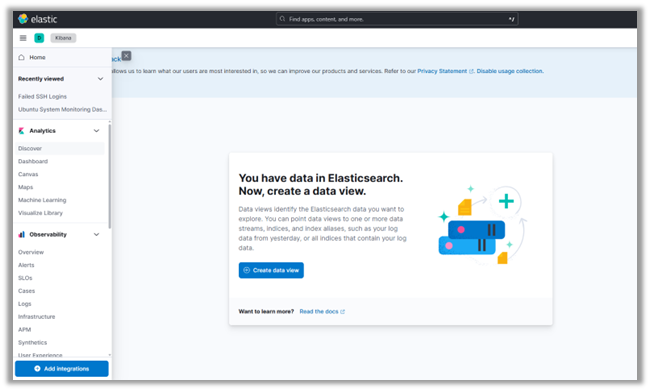

1. Revenez à l'interface Kibana.

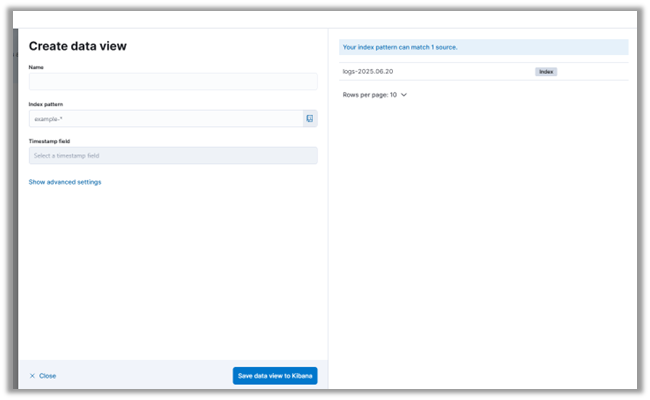

2. Dans le menu déroulant en haut à gauche, cliquez sur « Découvrir ». Vous serez invité à créer un nouveau modèle d'index, y compris une vue des données syslog par champ :

3. Cliquez sur « Créer un modèle d'index ».

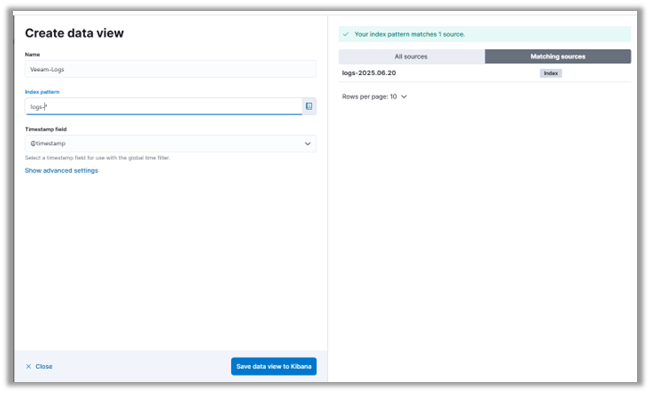

4. Vous pouvez voir que notre serveur Elasticsearch a déjà reçu des messages syslog de Veeam. Lorsque vous configurez les paramètres du serveur syslog dans Veeam, il envoie automatiquement un message de test. Cela vous permet de vérifier que votre système de surveillance ou SIEM reçoit correctement les journaux.

5. Nous nommerons notre modèle d'index Veeam_Logs et utiliserons un modèle d'index qui correspond aux journaux déjà ingérés.

6. Cliquez sur « Enregistrer le modèle d'index dans Kibana ».

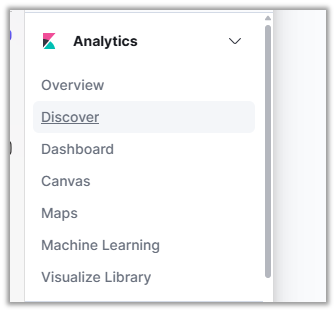

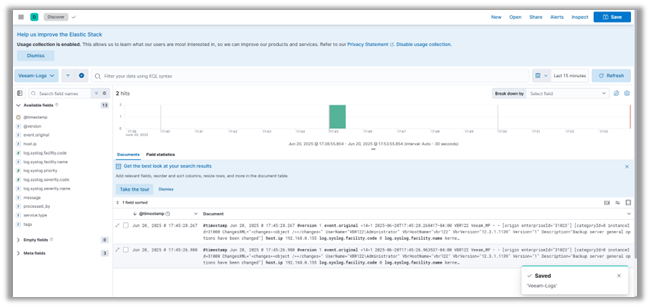

7. Appuyez sur "Découvrir" dans le menu sur le côté gauche de la page pour voir les messages journaux de VBR.

Conclusion

Avec votre laboratoire ELK opérationnel, vous avez franchi une étape majeure vers la construction d'un environnement SIEM fonctionnel. Dans cet article, nous avons parcouru la configuration des conteneurs Docker pour Elasticsearch, Logstash et Kibana, configuré un pipeline Logstash pour les messages syslog de Veeam, et exploré ces journaux dans Kibana. Vous avez maintenant une base solide pour ingérer et visualiser les données de journal dans un environnement de test contrôlé.

Dans le prochain article de la mini-série, nous allons nous appuyer sur cette base en plongeant dans Elastic Security et en explorant comment il améliore la détection des menaces et l'alerte au sein de l'écosystème ELK. Nous introduirons également Fluentd comme alternative à Logstash, en comparant les deux outils et en montrant comment configurer Fluentd pour transférer des journaux vers Elasticsearch. Si vous êtes intéressé par les cas d'utilisation de la surveillance de la sécurité, la création de tableaux de bord et l'optimisation de votre pipeline de journaux, vous ne voudrez pas manquer ce qui suit.