Pratica Pratica con il Stack ELK

Serie di Blog SIEM & Monitoring: ELK Stack

In questo secondo episodio della nostra mini-serie ELK Stack all'interno della più ampia Serie di Blog SIEM & Monitoring, ci spostiamo dai concetti fondamentali all'implementazione pratica. Questo post ti guiderà nella configurazione di un ambiente di test ELK funzionale utilizzando Docker su una macchina virtuale Ubuntu, offrendoti un sandbox per esplorare come Elasticsearch, Logstash e Kibana lavorano insieme per elaborare e visualizzare i dati.

Che tu sia un amministratore di backup o un professionista IT, questa guida offre un laboratorio personalizzabile dove puoi sperimentare con l'analisi dei messaggi Syslog di Veeam Backup & Replication e inoltrarli nel tuo stack ELK. L'obiettivo è fornire un ambiente sicuro e flessibile per l'apprendimento e il testing, non per il deployment in produzione.

Configurazione di Docker

Requisiti: Avrai bisogno di una VM server Ubuntu.

1. Prima di tutto, installeremo Docker:

sudo apt install docker.io

sudo apt install docker-compose -y

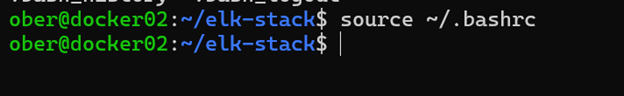

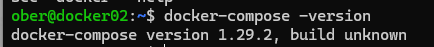

sudo usermod -aG docker $USER 2. Disconnettiti e riconnettiti, oppure esegui uno di questi comandi:

source ~/.bashrc

exec bash

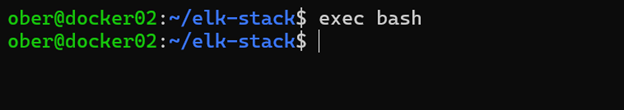

3. Disconnettiti e riconnettiti per verificare che Docker sia stato installato correttamente.

docker --version

docker compose version

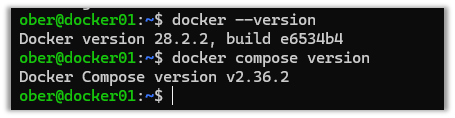

4. A seconda della versione, il comando Docker Compose potrebbe apparire in questo modo:

5. Clona questo repository GitHub: https://github.com/object1st/elk-stack.git

git clone https://github.com/object1st/elk-stack.git6. Accedi alla cartella.

cd elk-stack/7. Esegui questo comando:

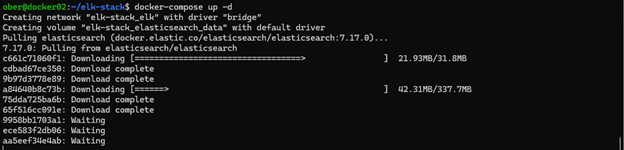

docker-compose up -d8. I contenitori verranno scaricati e poi avviati.

9. Controlla che uno dei seguenti contenitori sia in esecuzione:

docker ps

docker-compose ps

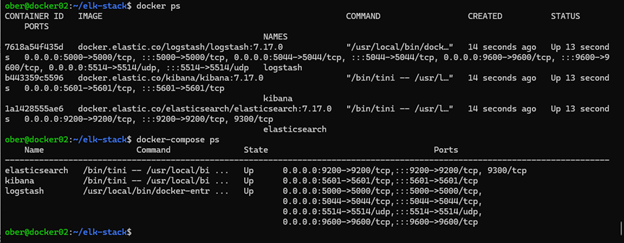

Accesso a Kibana nel tuo browser

Ora che tutto è configurato, puoi aprire Kibana nel tuo browser. Per impostazione predefinita, Kibana funziona sulla porta 5601, quindi dovrai navigare all'URL appropriato in base a dove è ospitato il tuo ambiente Docker.

Ad esempio, se la tua configurazione Docker è in esecuzione su una VM chiamata docker01, dovresti andare a:

Se la tua VM ha un nome DNS personalizzato come geoffsvm, allora l'URL sarebbe: http://geoffsvm:5601

In alternativa, se non hai un nome DNS configurato, puoi utilizzare l'indirizzo IP della VM:

http://[your-vm-ip]:5601:5601

In definitiva, assicurati solo di puntare all'host corretto e di utilizzare la porta 5601, che è quella predefinita per Kibana.

Nota: Se in qualsiasi momento desideri ricominciare da capo, esegui i seguenti passaggi per cancellare la configurazione:

Per rimuovere tutti i contenitori, le reti e i volumi esegui i seguenti comandi:

docker compose down --volumes --remove-orphans

docker system prune -a --volumes -fConfigurazione di Veeam VBR per Inviare Dati Syslog a ELK

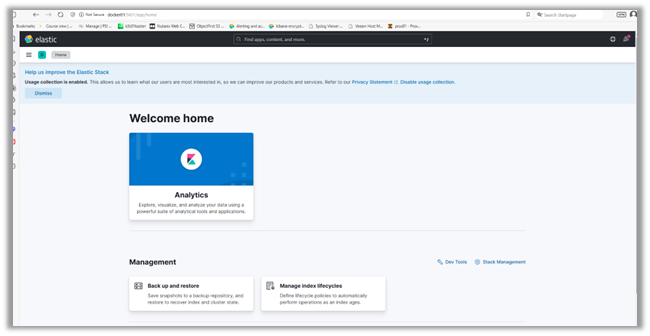

Per ingerire i log nella nostra configurazione per vedere come funziona, configureremo Veeam VBR per inoltrare i suoi messaggi syslog a ELK:

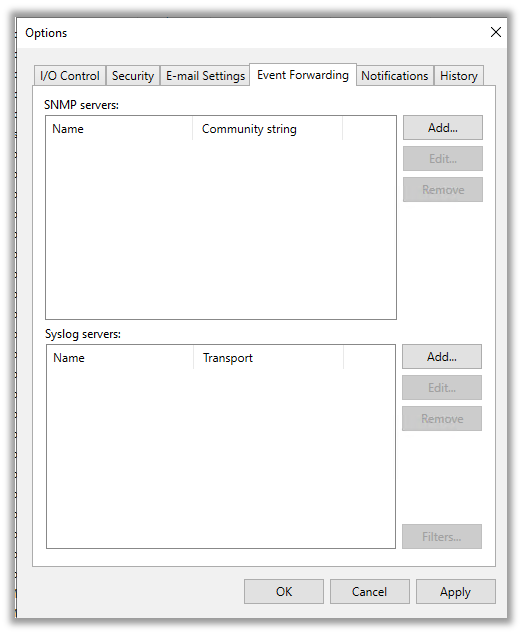

1. Vai al menu a discesa in alto a sinistra e clicca su “Opzioni.”

2. Poi clicca sulla “Scheda di Inoltro Eventi.”

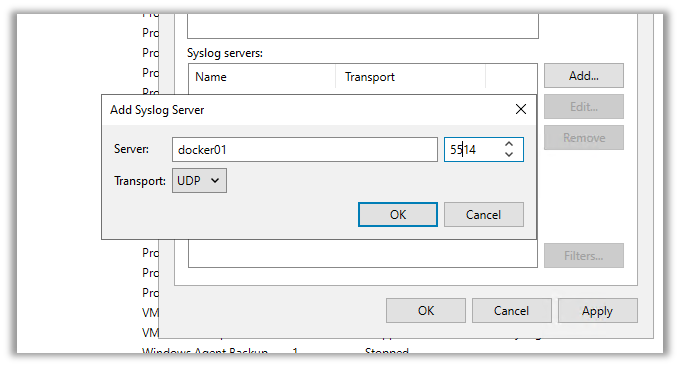

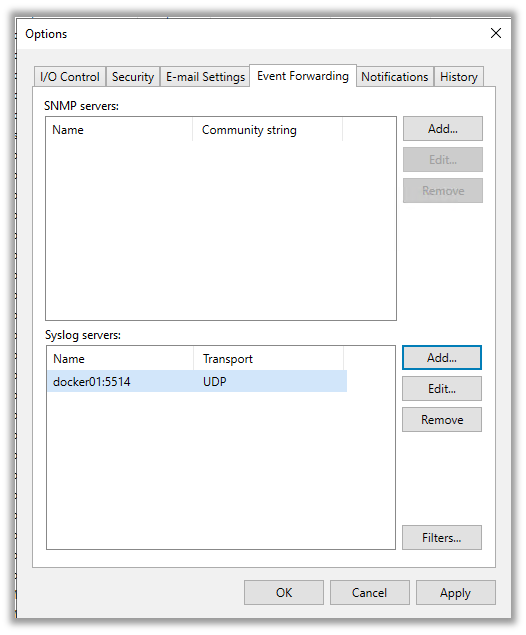

3. Qui, aggiungeremo il server syslog che abbiamo creato in Docker. Clicca su “Aggiungi” e inserisci i dettagli. Poi, clicca su uno dei seguenti:

- “Applica” per salvare e chiudere la finestra.

- “OK” per salvare e mantenere la finestra aperta.

Una volta che premi applica o ok, Veeam invierà il suo primo messaggio syslog di test a Elasticsearch.

Verifica della Scoperta dei Log in Kibana

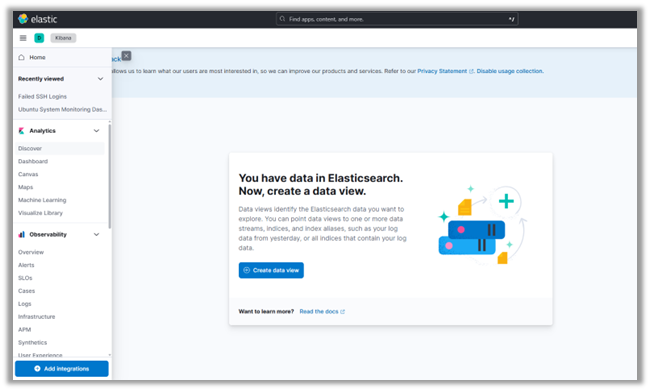

1. Torna all'interfaccia di Kibana.

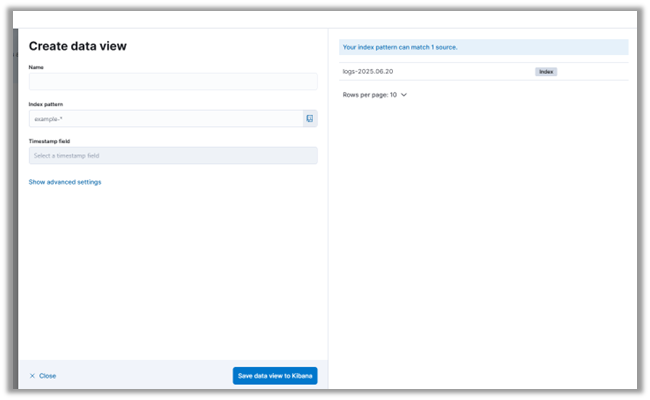

2. Nel menu a discesa in alto a sinistra, clicca su “Scopri.” Lì ti verrà presentato un invito a creare un nuovo Modello di Indice, inclusa una vista dei dati syslog per campo:

3. Clicca su “Crea Modello di Indice.”

4. Puoi vedere che il nostro server Elasticsearch ha già ricevuto alcuni messaggi syslog da Veeam. Quando configuri le impostazioni del server syslog in Veeam, invia automaticamente un messaggio di test. Questo ti consente di verificare che il tuo sistema di monitoraggio o SIEM stia ricevendo i log correttamente.

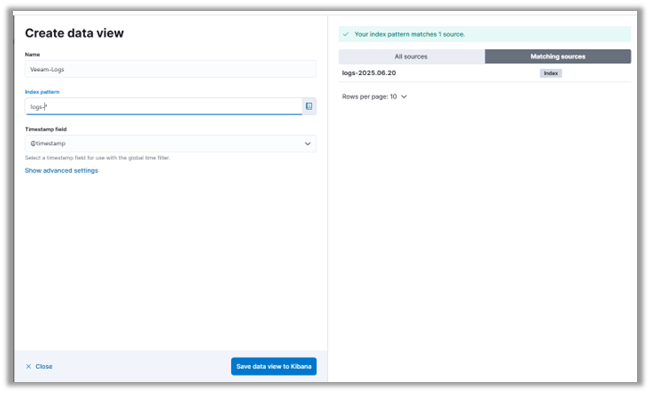

5. Daremo al nostro Modello di Indice il nome Veeam_Logs e utilizzeremo un Modello di Indice che corrisponde ai log già ingeriti.

6. Clicca su “Salva Modello di Indice in Kibana.”

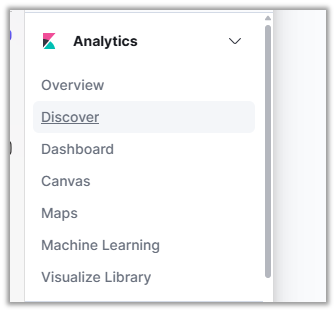

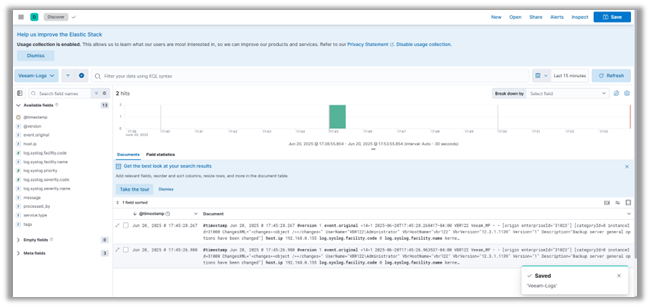

7. Premi "Scopri" nel menu a sinistra della pagina per vedere i messaggi di log da VBR.

Conclusione

Con il tuo laboratorio ELK attivo e funzionante, hai fatto un passo importante verso la costruzione di un ambiente SIEM funzionale. In questo post, abbiamo esaminato la configurazione dei contenitori Docker per Elasticsearch, Logstash e Kibana, configurato una pipeline Logstash per i messaggi syslog di Veeam, e esplorato quei log in Kibana. Ora hai una solida base per ingerire e visualizzare i dati di log in un ambiente di test controllato.

Nel prossimo post della mini-serie, costruiremo su questa base approfondendo Elastic Security e esplorando come migliora il rilevamento delle minacce e l'allerta all'interno dell'ecosistema ELK. Introdurremo anche Fluentd come alternativa a Logstash, confrontando i due strumenti e mostrando come configurare Fluentd per inoltrare i log a Elasticsearch. Se sei interessato a casi d'uso di monitoraggio della sicurezza, creazione di dashboard e ottimizzazione della tua pipeline di log, non vorrai perderti ciò che verrà dopo.